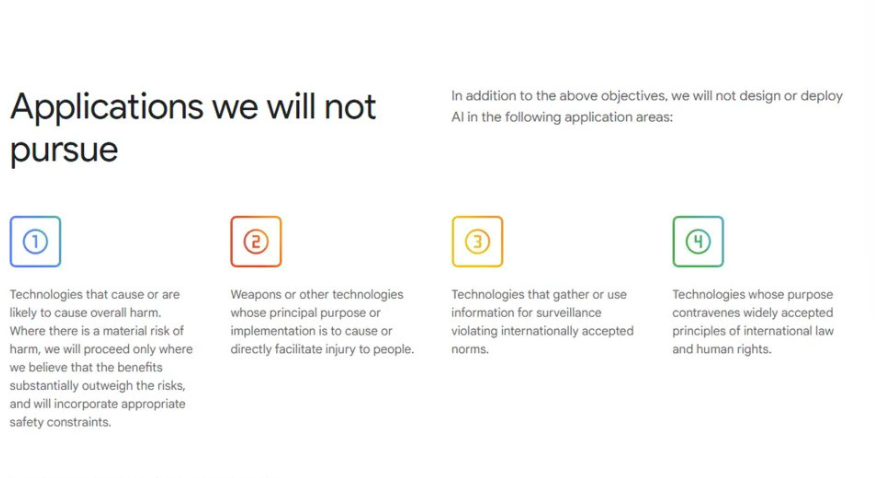

Η Google έκανε μία σημαντική αλλαγή στους όρους του “AI principles” που είχε θέσει το 2018, όταν είχε δηλώσει ότι δεν θα αναπτύξει AI εργαλεία για χρήση σε όπλα ή συστήματα παρακολούθησης. Πρόκειται για την πρώτη σημαντική αναθεώρηση των αρχών αυτών από την αρχική τους ανακοίνωση, με την εταιρεία τότε να προγραμματίζει “εφαρμογές της AI που δε θα επιχειρήσει να αναπτύξει”. Στην καινούργια της δήλωση, η Google τονίζει τη “υπεύθυνη ανάπτυξη” της AI, υπογραμμίζοντας τη σημασία της ανθρώπινης επίβλεψης και μηχανισμών ανατροφοδότησης που θα διασφαλίζουν ότι οι εφαρμογές της ευθυγραμμίζονται με κοινωνικές και ηθικές αξίες, καθώς και με διεθνείς νόμους και ανθρώπινα δικαιώματα.

Ο CEO της DeepMind, Demis Hassabis, απαντώντας σε ερωτήσεις για αυτή την αλλαγή, δήλωσε ότι η αναθεώρηση της πολιτικής ήταν αναγκαία λόγω της εξέλιξης της AI σε μία “τεχνολογία γενικής χρήσης”. Ο Hassabis τόνισε την ανάγκη οι δημοκρατίες να ηγούνται στην ανάπτυξη της AI, βασιζόμενες σε αρχές όπως η ελευθερία, η ισότητα και ο σεβασμός στα ανθρώπινα δικαιώματα. Πρόσθεσε ότι οι εταιρείες, οι κυβερνήσεις και οι οργανισμοί που μοιράζονται αυτές τις αρχές πρέπει να συνεργαστούν για να δημιουργήσουν μια AI που θα προστατεύει τον κόσμο, θα προωθεί την παγκόσμια ανάπτυξη και θα ενισχύει την εθνική ασφάλεια.

Αξιοσημείωτο είναι ότι οι “AI principles” της Google δημιουργήθηκαν το 2018, μετά από έντονη αντίδραση που προκλήθηκε από το Project Maven, ένα κυβερνητικό πρόγραμμα με το οποίο η Google είχε προγραμματίσει να συνεργαστεί με το Υπουργείο Άμυνας των ΗΠΑ για τη δημιουργία AI λογισμικού για τα στρατιωτικά drones. Η αντίδραση αυτή οδήγησε σε παραιτήσεις από δεκάδες υπαλλήλους της Google και χιλιάδες υπογραφές διαμαρτυρίας κατά του project.